DCAMNet钢铁缺陷检测网络复现

代码链接

DCAMNet个人修改后的代码链接,非官方!!!!,侵权请在文章尾部联系删除

YOLOX网络结构与DCAMNet改进

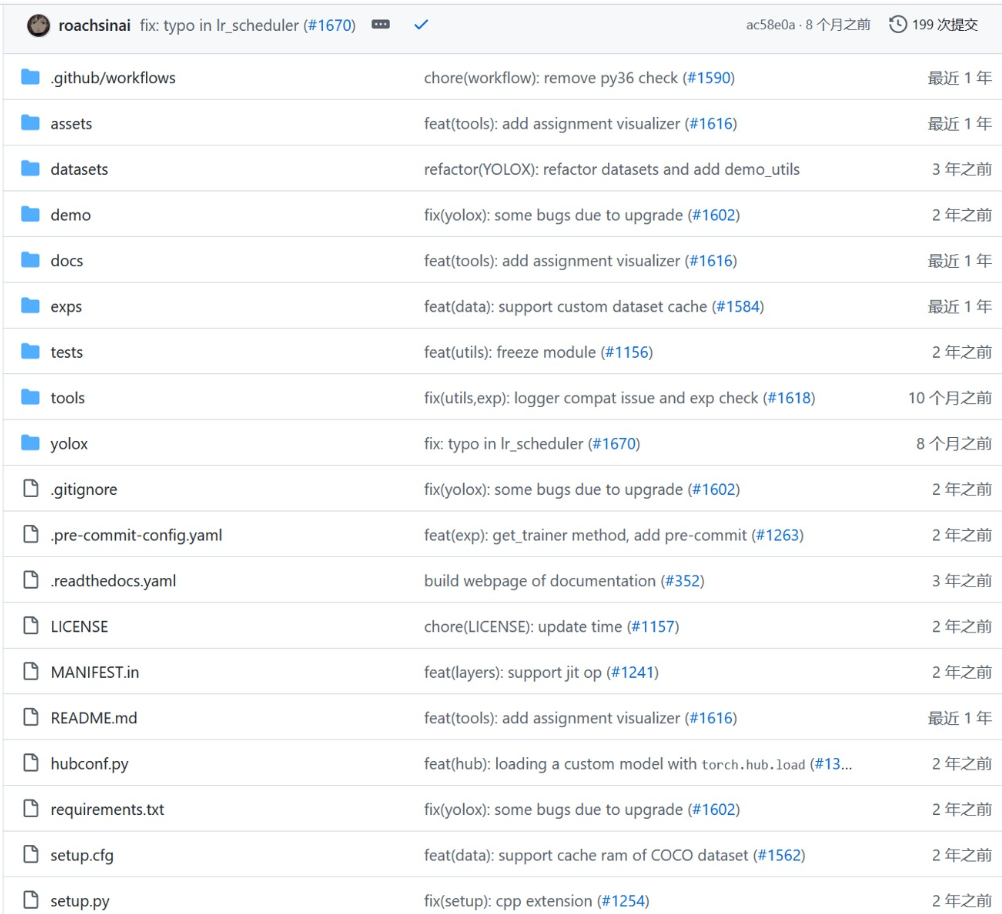

YOLOX代码结构概述

文件夹结构

dataset: 包含两种数据集样式,COCO2017(JSON格式)和VOC2017(YML文件格式)。

demo: 提供基于 MegEngine、ONNX、TensorRT、OpenVINO 和 ncnn 的部署示例。

MegEngine: 面向深度学习的框架,适合不同设备上的模型推理和部署。

ONNX: 用于表示深度学习模型的开放格式,支持跨不同框架之间的模型共享和转换。

TensorRT: 用于高性能深度学习推理的 NVIDIA 推理加速库。

OpenVINO: 由英特尔提供的开源工具包,用于加速计算机视觉应用的开发和部署。

NCNN: 面向移动端的高性能神经网络计算库,主要针对 ARM 架构优化。

Exps: 包含了对 YOLOX 文件的所有使用的配置文件。

MegEngine

MegEngine 是端到端深度学习框架,支持动态计算图和自动微分功能。

采用静态图优化、异步执行和自动内存管理,提高计算效率和资源利用率。

支持多种硬件后端,包括 CPU、GPU 和 AI 加速器。

ONNX

ONNX 是表示深度学习模型的开放格式,旨在实现跨不同框架和工具的模型互操作性。

使用中间表示(Intermediate Representation)表示模型结构和参数。

提供用于转换和优化模型的工具和库。

TensorRT

TensorRT 是 NVIDIA 提供的用于高性能深度学习推理的推理加速库。

针对 NVIDIA GPU 进行了优化,支持网络剪枝、量化和层次融合等优化技术。

支持多种硬件平台,提供用于优化和部署深度学习模型的工具和库。

OpenVINO

OpenVINO 是英特尔提供的工具包,用于优化和部署计算机视觉和深度学习模型。

利用模型优化技术,如量化、异步推理和硬件加速,使模型能够在英特尔的不同硬件上高效运行。

提供模型优化和部署的工具,适用于边缘计算和嵌入式设备。

NCNN

NCNN 是面向移动端和嵌入式设备的高性能神经网络计算库,主要针对 ARM 架构优化。

采用轻量级设计和高效的推理引擎,通过优化算法和硬件指令集提高模型在移动设备上的推理速度和效率。

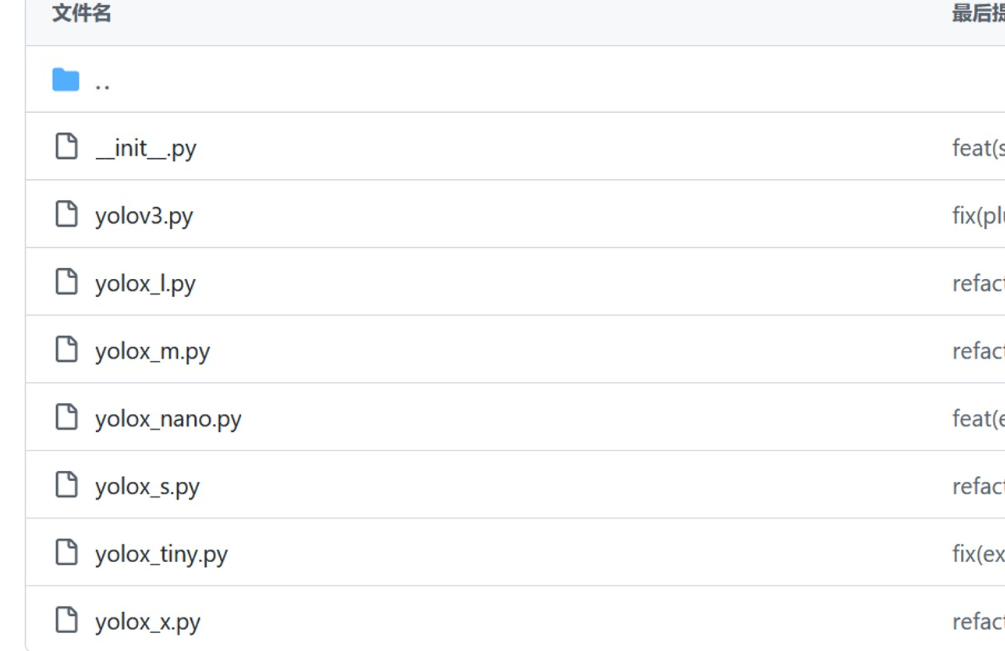

Exps文件夹

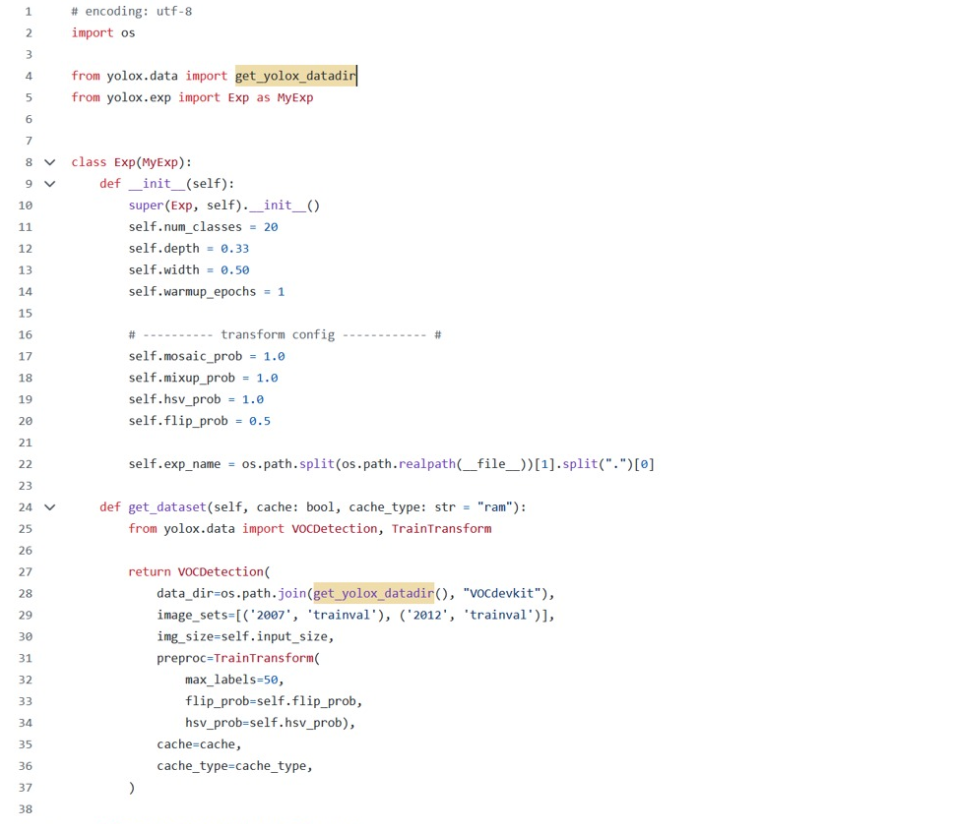

- yolox_s: 本次修改我们使用该文件夹中的配置文件,定义了一些关键参数,如类别数、模型深度、宽度等。

Exp类: 继承了 YOLOX 的实验配置类 MyExp,重写了一些方法和属性,用于配置实验的细节。

init 方法: 设置模型训练参数,如类别数、模型深度、宽度等。

get_dataset 方法: 获取训练数据集,设置预处理参数,如 mosaic_prob(拼接图像的概率)、mixup_prob(混合训练的概率)等。

get_eval_dataset 方法: 获取评估所需的数据集,设置评估数据的相关参数。

get_evaluator 方法: 获取评估器,用于评估模型在数据集上的性能。

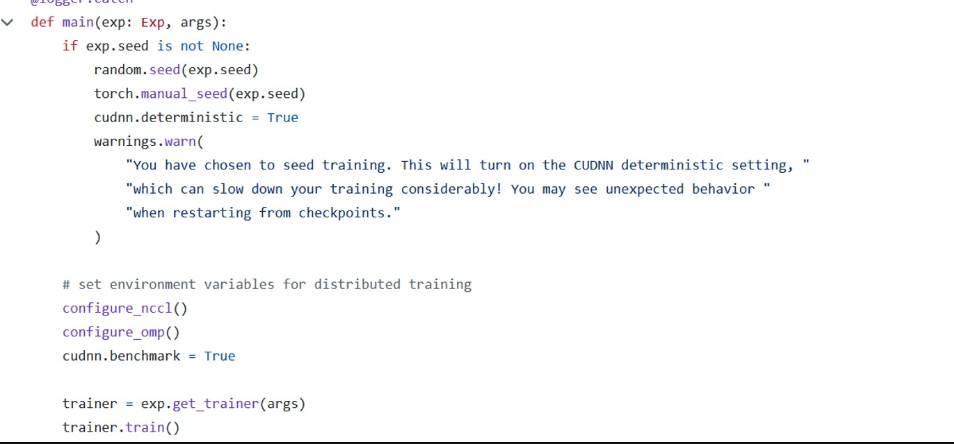

Tools文件夹

- train 文件: 用于传递各种训练参数。

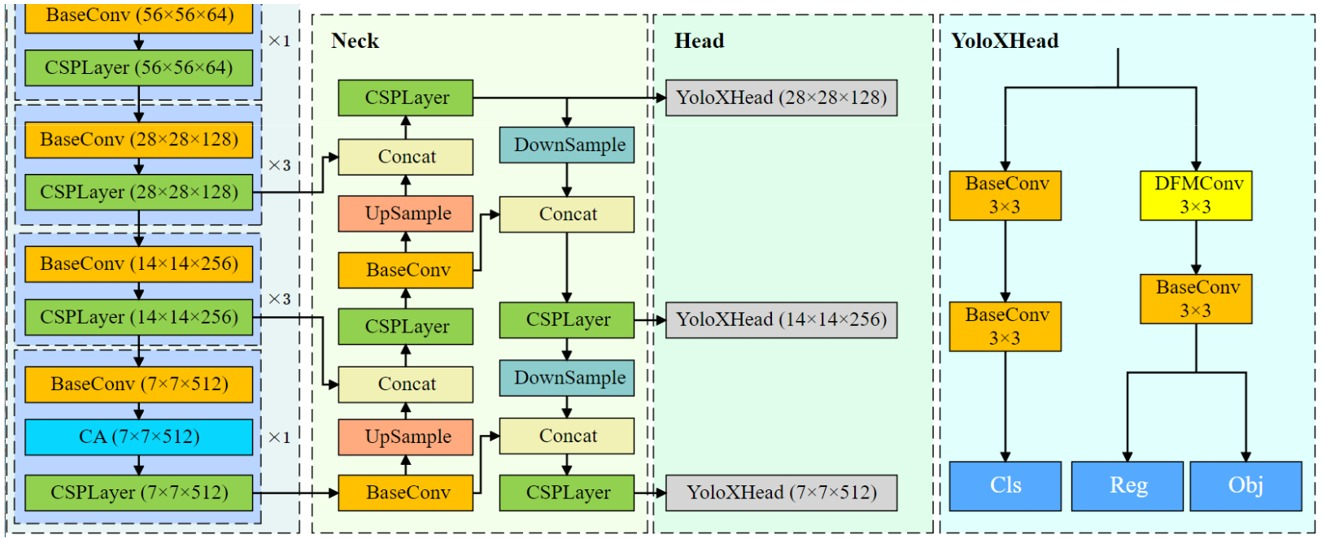

YOLOX网络结构

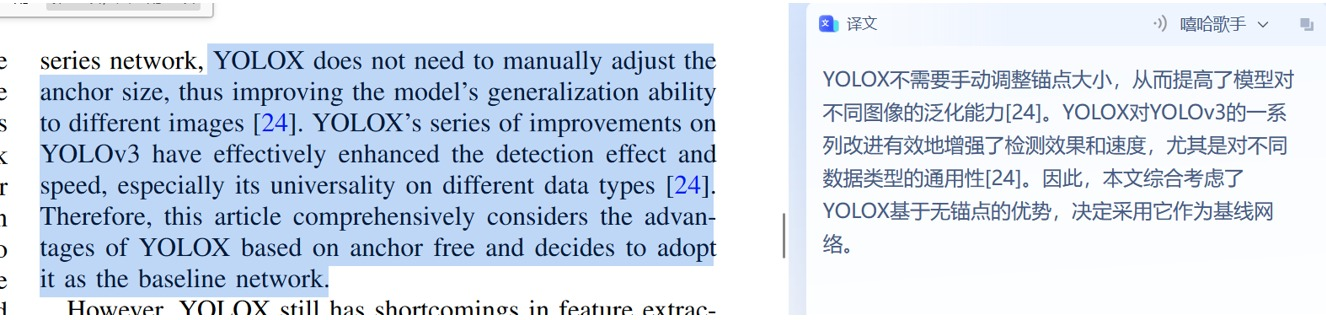

YOLOX 检测算法基于 YOLO 系列,但对锚框生成模式进行了改进,引入无锚定(anchor-free)技术。

选择 YOLOX 作为基线网络,因其在不同数据集上的泛化能力较强,相对于传统锚框生成方法更灵活。

YOLOX 不需要手动调整锚框大小,提高了模型泛化能力。

YOLOX选择原因

现阶段检测算法的问题: 在YOLO系列上的检测头主要采用的聚类方法会导致模型在不同数据集上的泛化能力较差,训练后生成的锚框大多不能使用,导致大量的计算冗余,从而提高了计算成本和检测速度。而在带钢的表面缺陷图像数据中,由于缺陷之间的显著差异,聚类得到的锚框的大小更容易不稳定,会进一步影响检测网络模型的检测效果。

为什么选择YOLOX: 对比于YOLO系列网络,YOLOX检测头部分用无锚定(anchor-free)技术取代了基于锚定的技术。采用匈牙利算法作为参考,并设计了简化最优传输分配匹配算法,以减少模型训练过程中的许多冗余锚框。YOLOX不需要手动调整锚框的大小,从而提高了模型对不同图像的泛化能力。YOLOX对YOLOv3上的一系列改进有效地提高了检测效果和速度,特别对不同图像上的泛化性,所以作者选择了YOLOX作为基线网络。

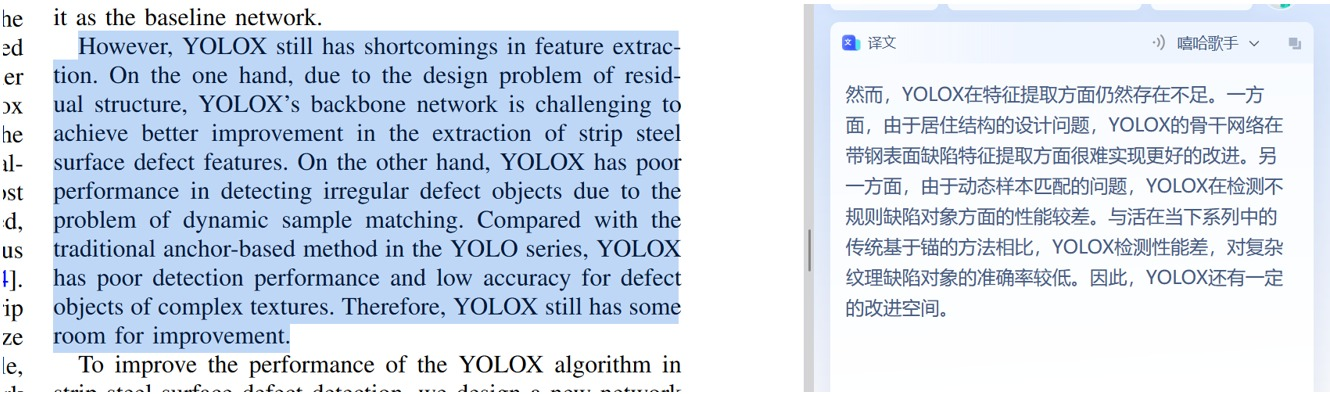

- 现阶段YOLOX仍有的不足之处: 由于残余结构的设计问题,YOLOX的骨干网络难以更好地改进带钢表面缺陷特征的提取,再就是由于动态样本匹配的问题,YOLOX在检测带钢这种不规则缺陷对象方面的性能较差。与YOLO系列中传统的anchor-based的方法相比,YOLOX对复杂纹理的缺陷对象的检测性能较差,精度较低。

DCAMNet 改进

数据集修改

- 将数据集分为测试集和训练集,按照 VOC 格式修改数据集格式。

模型改进

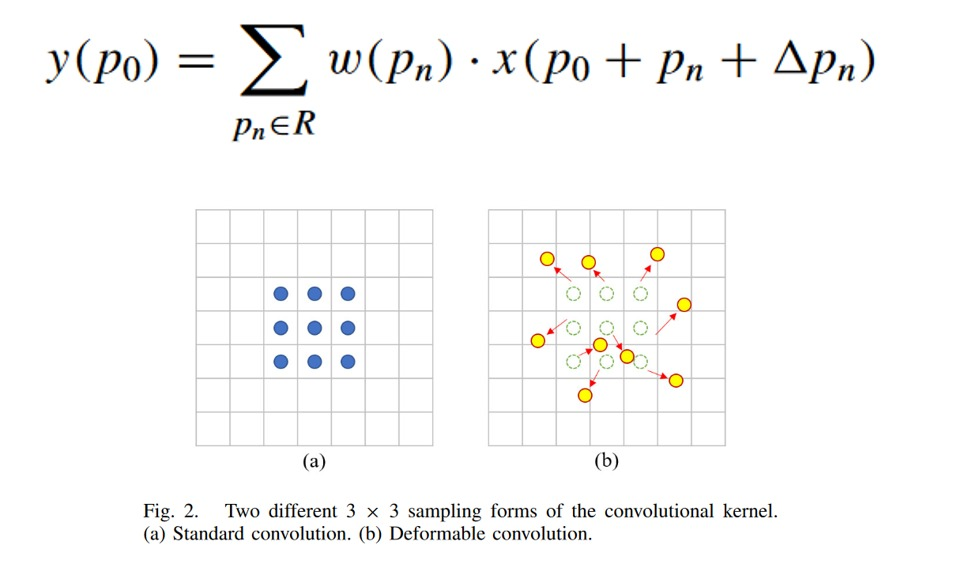

- CSPLayer 添加可变性卷积(EDE-block):

在 network_blocks.py 添加 EDE_block 部分的代码,包括 DFMConv 模块和 3x3 BaseConv。

在 CSPLayer 中修改代码,添加 EDE_Block 并删除原有的循环串联结构。

- DarkNet 中添加 CA 模块:

实现 CA 模块,替代 SPP 结构。

将实现的 CA 模块添加到 Dark5 中。

- 检测头改进:

- 在 YOLOX 的检测头中,将一个 BaseConv 替换为 DFMConv。

EIoU损失函数

引入 EIoU 损失函数,替代 IoU 损失函数,加速训练过程,提高回归准确性。

EIoU 损失函数包括 IoU 损失、距离损失和宽高比损失。

改代码步骤

- CSPLayer 添加可变性卷积:

- 修改 YOLOX 中的 CSPLayer,加入 EDE_block。

1 | class EDE_block(nn.Module): |

其中DeformConv代码如下:

1 |

|

有了EDE即可完成CSPlayer

1 |

|

- DarkNet 中添加 CA 模块:

- 实现 CA 模块,替代 YOLOX 的 SPP 结构。

1 |

|

- 将 CA 模块添加到 Dark5 中。

1 | # dark5 |

- 检测头改进:

- 在 YOLOX 的检测头中,将 BaseConv 替换为 DFMConv。

1 |

|

结论

通过以上改进,DCAMNet 在带钢表面缺陷检测中引入了可变性卷积、注意力机制和 EIoU 损失函数,提高了对不规则缺陷的检测性能和泛化能力。这些改进使得 DCAMNet 在复杂场景中更具优势,对不同形状、大小和纹理的缺陷有更好的适应性。

参考文章概述

以下是关于 DCAMNet 网络的学习笔记与复现指南的参考文章,供学者深入了解该算法及实现过程。

- 该文章深入解析了 DCAMNet 网络的结构和关键创新,为理解 DCAMNet 提供了详实的学习笔记。

- DCAMNet 论文的原始链接,提供了算法设计和实验结果等详尽信息。

- 该文章详细介绍了如何复现 DCAMNet 算法,为读者提供了实际操作的指导,包括环境配置和代码实现。

- 对 YOLOX 算法进行讲解,为理解 DCAMNet 基于 YOLOX 的改进提供了背景知识。

- 介绍 YOLOX 网络结构,为理解 DCAMNet 基于 YOLOX 的修改提供了基础。

- 对 YOLOX 代码进行解析,为读者提供了深入了解 YOLOX 实现细节的资料。

- 提供了一个配置好的 VOC_YOLOX 代码库,其中包含中文注释,为读者提供了可直接运行的代码实例。

注意事项

- 以上内容仅供学术研究和学习交流使用,如有侵权,请联系我进行删除处理。

- 若有任何问题或需要进一步讨论,请随时联系我的邮箱:01@liushen.fun。