windows本地部署DeepSeek-R1模型

碎碎念

最近,在学习之余,我关注到了一个备受瞩目的热点话题——deepseek。这个横空出世的AI模型不仅效果超越了同期顶级AI,离谱的是,参数量不增反降的情况下,性能却大幅提升。最重要的是,deepseek是一个开源模型,这意味着人人都能享受到AI的强大力量。国内科技爱好者们对此激动不已,纷纷热议这一突破性进展。

然而,随着deepseek的崛起,外界似乎开始感到不安,试图通过网络攻击等手段打压这个新生企业。但令人振奋的是,中国的红客们屡次成功反击,植入大悲咒,小鸟壁纸等,相关新闻频频登上热搜。这一系列事件让我对deepseek产生了浓厚的兴趣,决定亲自尝试将其部署到本地,体验一下这个强大的AI模型。

出乎意料的是,部署过程异常简单。下面,我将与大家分享在Windows系统上部署deepseek的全过程。为了让大家能够更方便地使用这个模型,我还在网上搜寻并筛选出来了四五款本地使用的ollama可视化工具,一并分享给大家。希望这些工具能够帮助大家更直观、更高效地体验deepseek的魅力。

好的,下面是一个更加官方且规范的版本:

前期要求

硬件要求

在本地部署DeepSeek-R1模型之前,请确保你的电脑的硬件符合以下要求:

- 处理器:支持x86_64架构的

Intel或AMD处理器。 - 图形处理单元(GPU):请确保你的电脑有一个市面主流GPU,虽然

Ollama可以在纯CPU环境下跑,但是速度上会慢许多。 - 内存:最低要求8GB RAM,推荐16GB RAM以确保良好的系统性能。

- 存储空间:至少10GB的可用存储空间,推荐使用固态硬盘(SSD)以提供更快的数据读写速度。

软件要求

请确保您的系统安装并配置了以下软件环境:

- 操作系统:

Windows 10或更高版本(64位),以确保与Ollama工具的兼容性。 - Ollama:本项目采用

Ollama进行模型部署。请根据官方文档安装并配置Ollama工具。 - Node.js(可选):若需要与前端进行交互或进行脚本调试,推荐安装

Node.js环境,在可视化面板的部署中有部分项目依赖于NodeJS。

个人要求

为确保能够顺利完成DeepSeek-R1模型的部署,建议具备以下个人技能:

- 命令行基础:能够理解并处理命令行中的错误信息,具备基本的调试能力,能够定位并解决常见的配置问题。

- 环境变量配置:能够在Windows操作系统中自行配置环境变量,确保相关工具和软件能够正常运行。

- 问题排查能力:具备自主解决部署过程中可能遇到的常见问题的能力,能够查阅文档或社区资源进行有效的故障排除。

当然,本次模型部署并不困难,并且在这个教程中,我也会尽可能地再度零基础小白化,只要你有必要的硬件条件,相信你一定可以做到滴!

部署教程

安装Ollama

首先我们需要安装Ollama,Ollama是一个简便的本地机器学习模型部署工具,专为简化大规模模型的运行而设计。它支持在Windows和Linux等操作系统上部署深度学习模型,并且不依赖Python或其他复杂的框架,能够快速在本地环境中进行推理,使得模型能够高效利用本地硬件资源,适合需要快速部署和低配置环境的用户。

在网上搜索,我们可以很容易的找到他的官网,地址如下:

点击下载后安装即可,由于官网地址可能会稍微有点慢,我查找了一下,在他的github的软件包中同样有安装包,所以可以利用github地址,并通过开源加速地址进行下载,下载地址如下,地址可能具有时效性:

1 | https://ghproxy.cn/https://github.com/ollama/ollama/releases/download/v0.5.7/OllamaSetup.exe |

当然你也可以直接使用免安装版,直接解压到指定位置即可,地址如下:

在github的软件包中有多种选择,为不同操作系统的不同指令集,大部分windows电脑推荐选择ollama-windows-amd64.zip版本

使用可执行文件安装,会将Ollama自动安装到C盘下,后续的模型也会自动安装到安装目录下,如果你想将其移动到D盘,可以根据下面的说明继续安装,如果C盘空间足够大,且并不在意安装路径,可以直接点击快捷地址跳到下一部分。快捷地址

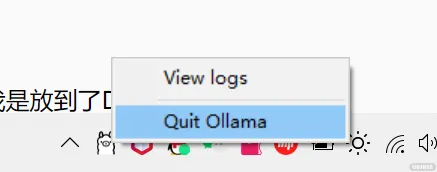

此时注意,在安装完成后,Ollama会自动运行,请在电脑右下角桌面角标处退出Ollama,防止由于运行中导致后续操作无法正确执行。

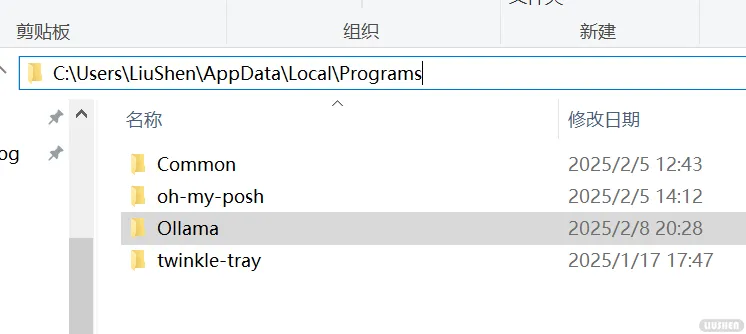

如果你和我一样,使用了安装程序安装,我们可以将其手动移动到D盘。找到Ollama安装地址,默认为下图地址:

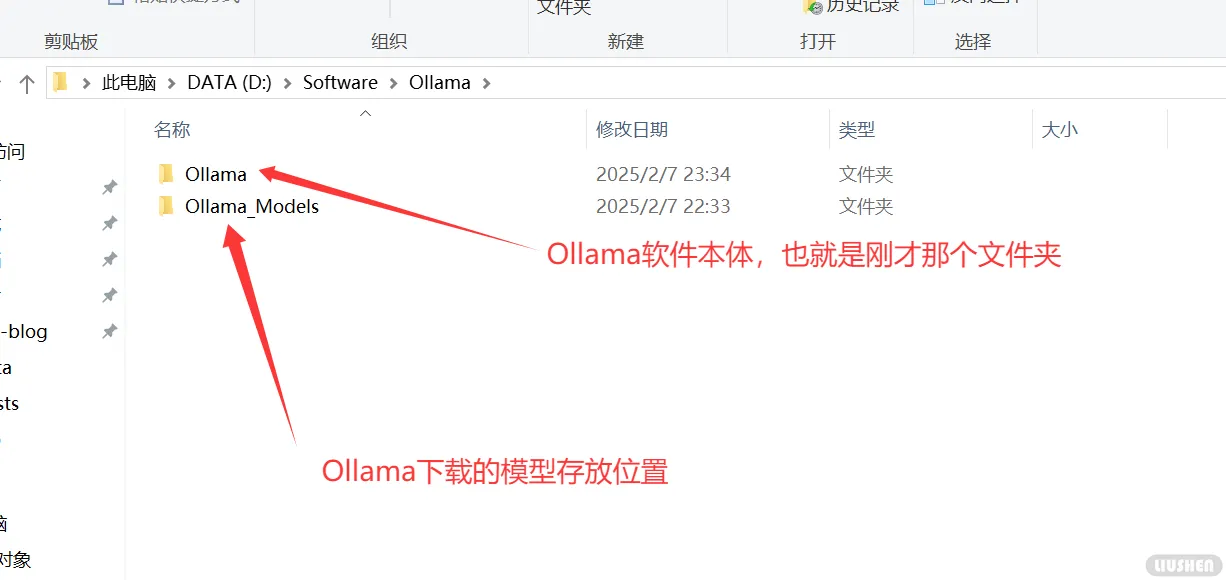

将其整个剪切粘贴到你想要安装到的位置,理论上任何位置都可以,尽量不要包含中文路径,比如我是放到了D盘,文件结构如下:

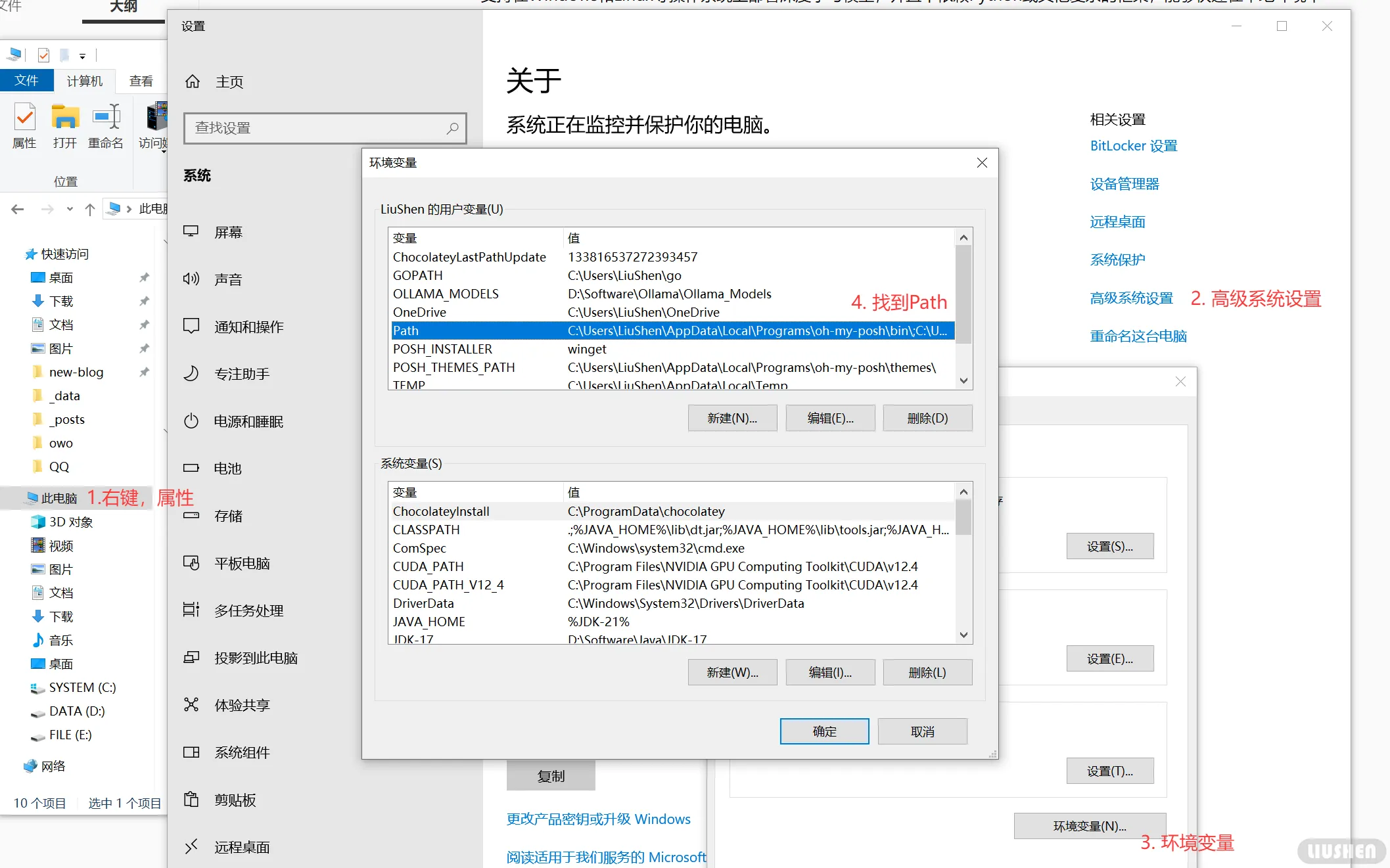

由于Ollama是命令行驱动的,我们需要修改他的系统变量,才能让windows找到可执行文件。右键我的电脑,属性,高级系统设置,环境变量,在用户系统变量中找到Path:

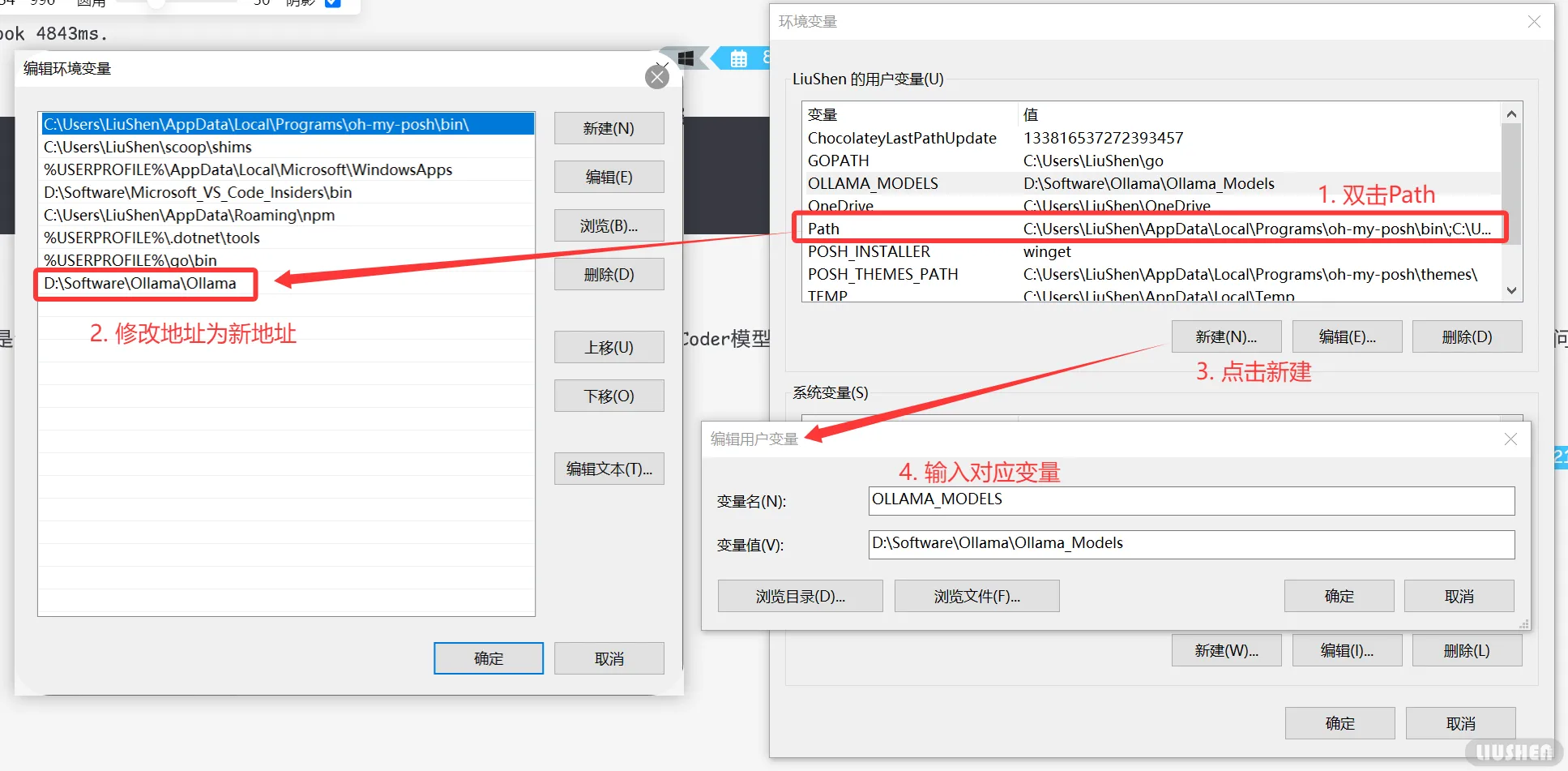

双击打开后,你应该会发现最下面一行多了一个Ollama的地址,指向原地址,将其修改刚才修改后的文件夹地址,如果一切正确,在这个地址下,应该会有一个Ollama.exe的可执行文件,然后再在用户变量下创建变量OLLAMA_MODELS,并填入模型保存地址,以后拉取的模型都会保存到这个路径下。如下图所示:

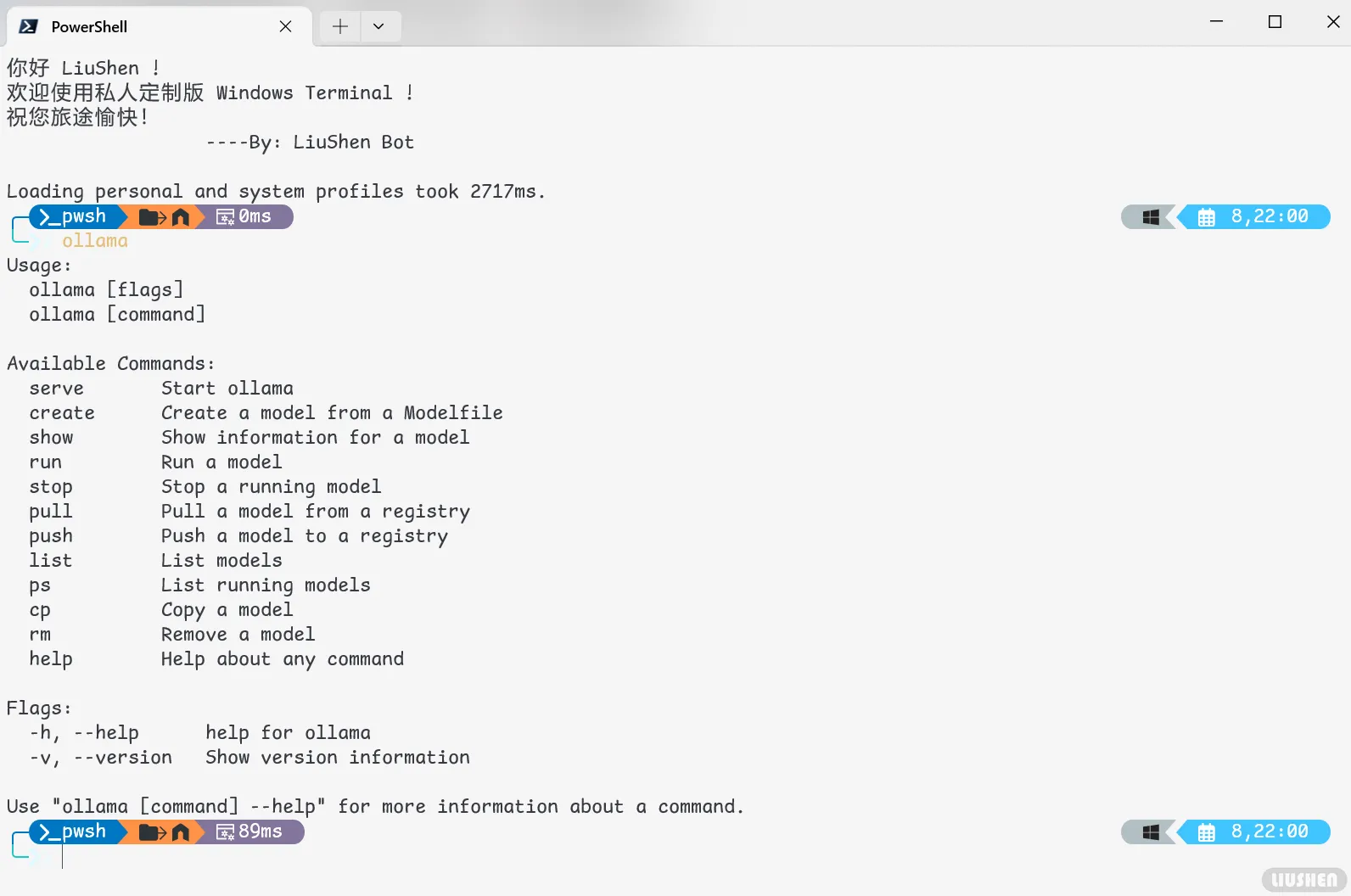

修改后,如果一切正常,安装应该就完成了,打开终端,输入ollama,应该就可以看到系统响应的指令啦!

模型部署

ollama下载好了,首先我们来学习一下他的简单指令,ollama的指令很简单,最基本的只有两类:

1 | ollama [flags] # 使用标志(flags)运行 ollama。 |

- 可用指令:

- serve:启动 ollama 服务。

- create:根据一个 Modelfile 创建一个模型。

- show:显示某个模型的详细信息。

- run:运行一个模型。

- stop:停止一个正在运行的模型。

- pull:从一个模型仓库(registry)拉取一个模型。

- push:将一个模型推送到一个模型仓库。

- list:列出所有模型。

- ps:列出所有正在运行的模型。

- cp:复制一个模型。

- rm:删除一个模型。

- help:获取关于任何命令的帮助信息。

- 可用标志:

- -h, –help:显示 ollama 的帮助信息。

- -v, –version:显示版本信息。

以上命令来源于菜鸟教程,具体看文末外部引用。

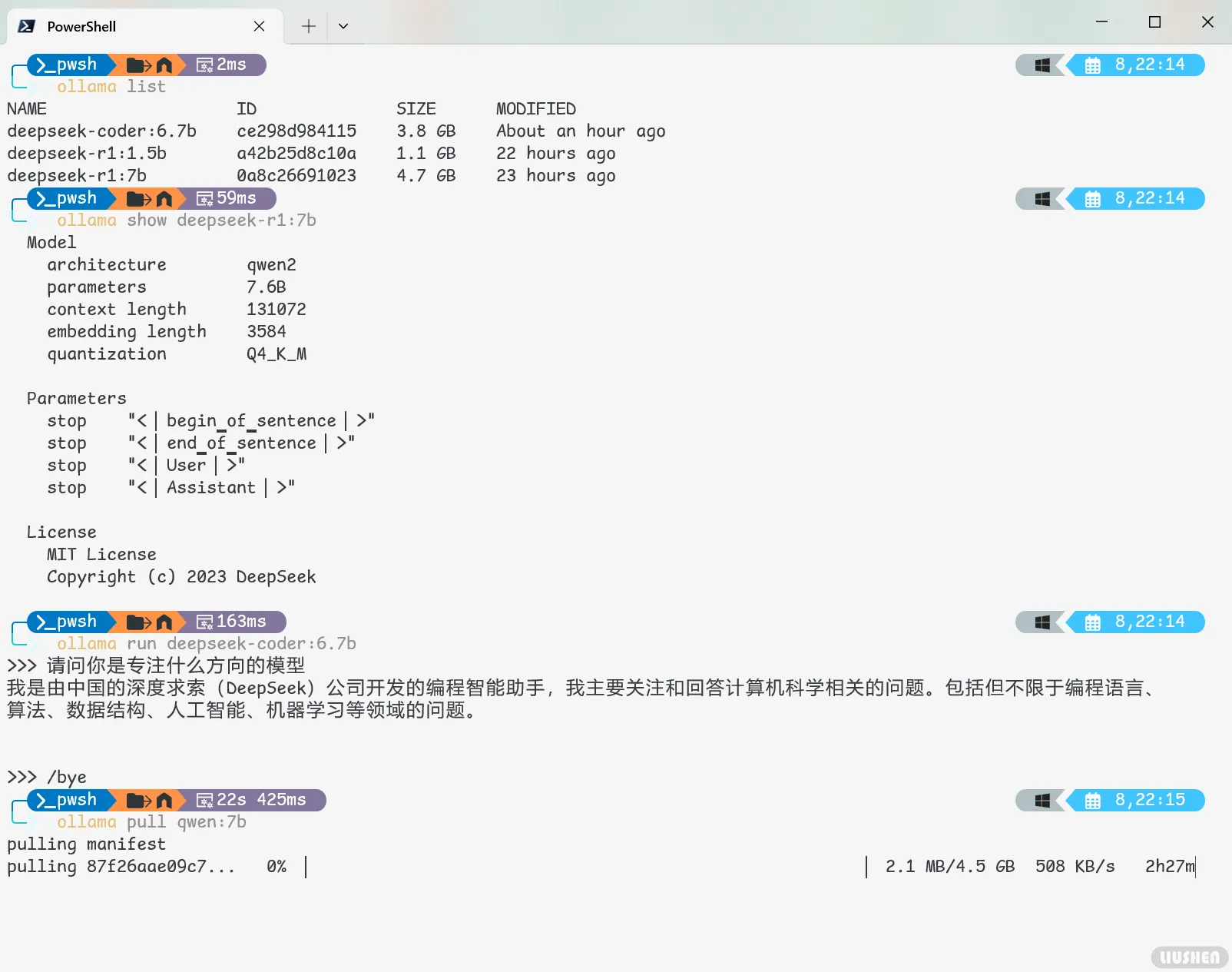

这里我们只挑几个最为常见的命令进行展示,如下图所示:

学会了基本用法,下面我们就来本地部署模型吧!首先拉取deepseek的模型,有如下几种选择,请按照电脑要求自行选择:

1 | ollama pull deepseek-r1:1.5b # 轻量化选择 |

Ollama可以在纯CPU情况下跑,但是速度上会慢很多,所以如果想要尝鲜可以从低配置下开始测试。

系统:Windows 10 22H2 专业工作站

CPU:R7-5800H

GPU:RTX3060 LAPTOP

显存:6GB

内存:16GB

PS:运行7B模型没有压力,没有向上继续测试

除了这些模型,还有各种不同参数量的模型,具体可以看下面网址中的模型列表:

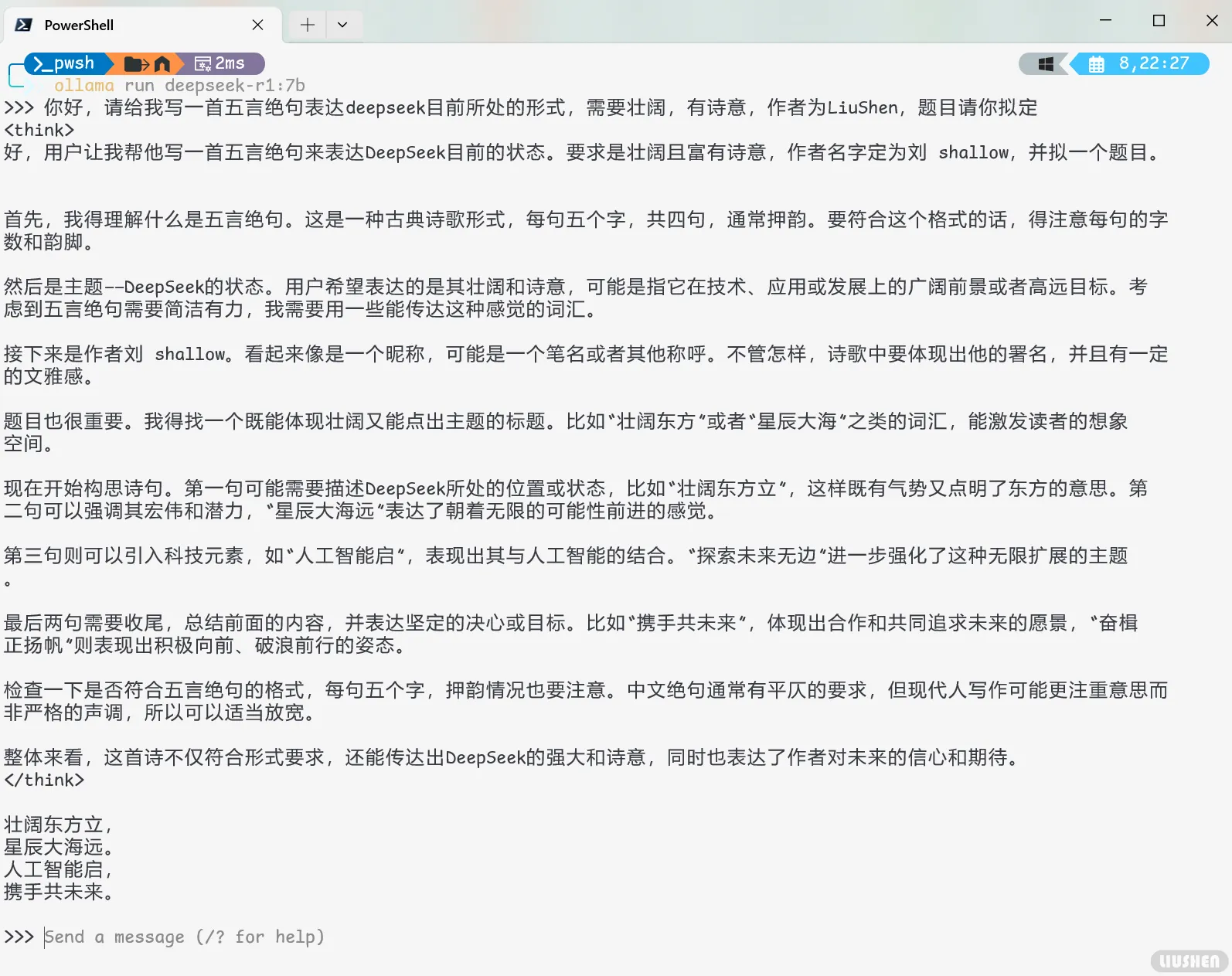

等待一段时间,模型拉取成功后,就可以开始跑了,通过以下命令,这里以deepseek-r1:7b作为演示:

这样,你就完整的跑完deepseek模型啦!

可视化工具

为了更加方便的进行对话,我找到了网上的众多应用,但是很多项目部署起来都比较麻烦,比如官方的需要docker进行部署,这违背了我简单体验的初衷,所以我尝试找一些较为方便的应用,最终筛选出了下面四个,排序即为推荐指数。

Cherry Studio

推荐指数:✮✮✮✮✮

推荐原因:界面美观,功能全面,安装即可使用

这个是我比较推荐的一个应用,不同于官方的需要自行配置环境才能测试,Cherry Studio仅仅需要下载安装即可,并且对输出的深度思考的结果也进行了一定的美化,唯一缺点可能是功能太多了,导致稍微有点杂?

地址如下:

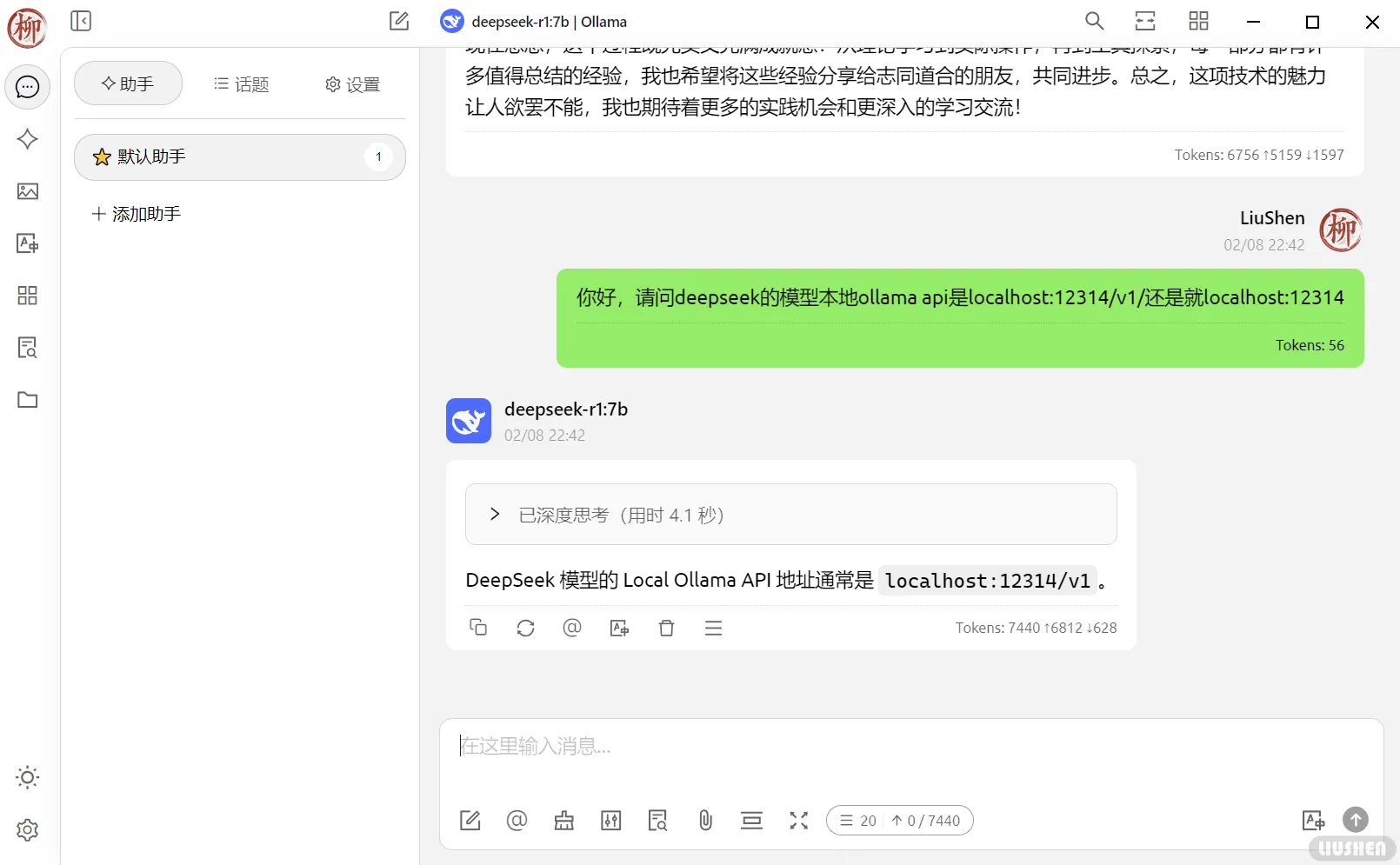

配置也很简单,只需要在设置中,打开ollama后,设置api地址并添加模型列表即可,如下图所示:

下面简单体验一下,在页面顶部即可选择模型,这里我们选择7b并尝试询问:

该软件将深度思考的过程折叠了起来,而不是像某些软件按照命令行中的<think>原样展示,并且页面上的UI也极具美观性。

ChatBox

推荐指数:✮✮✮✮

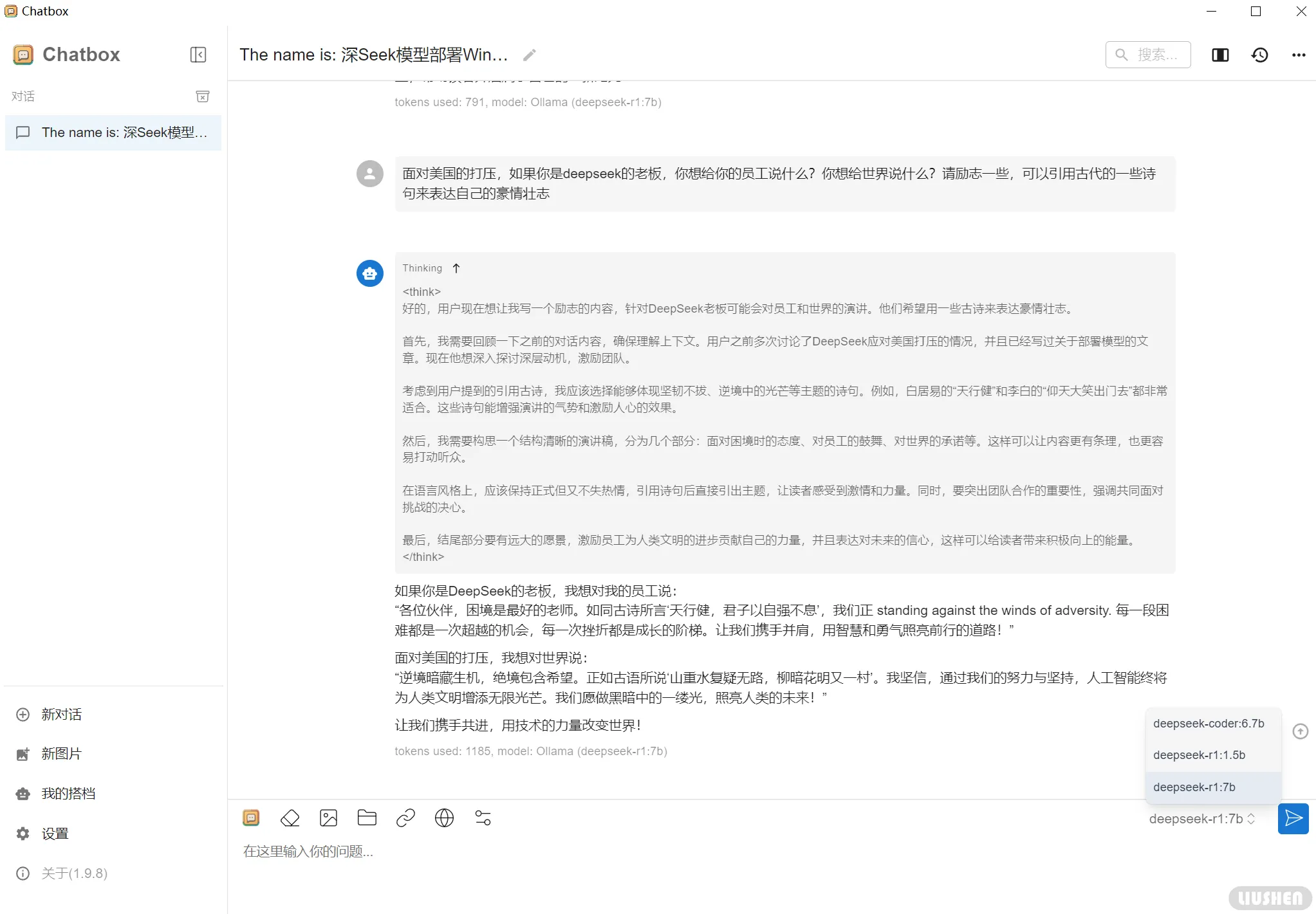

推荐原因:简单直观,比上面那个稍微差点,但是更加轻量化,对深度思考部分没有进行过多美化。

下面是安装地址:

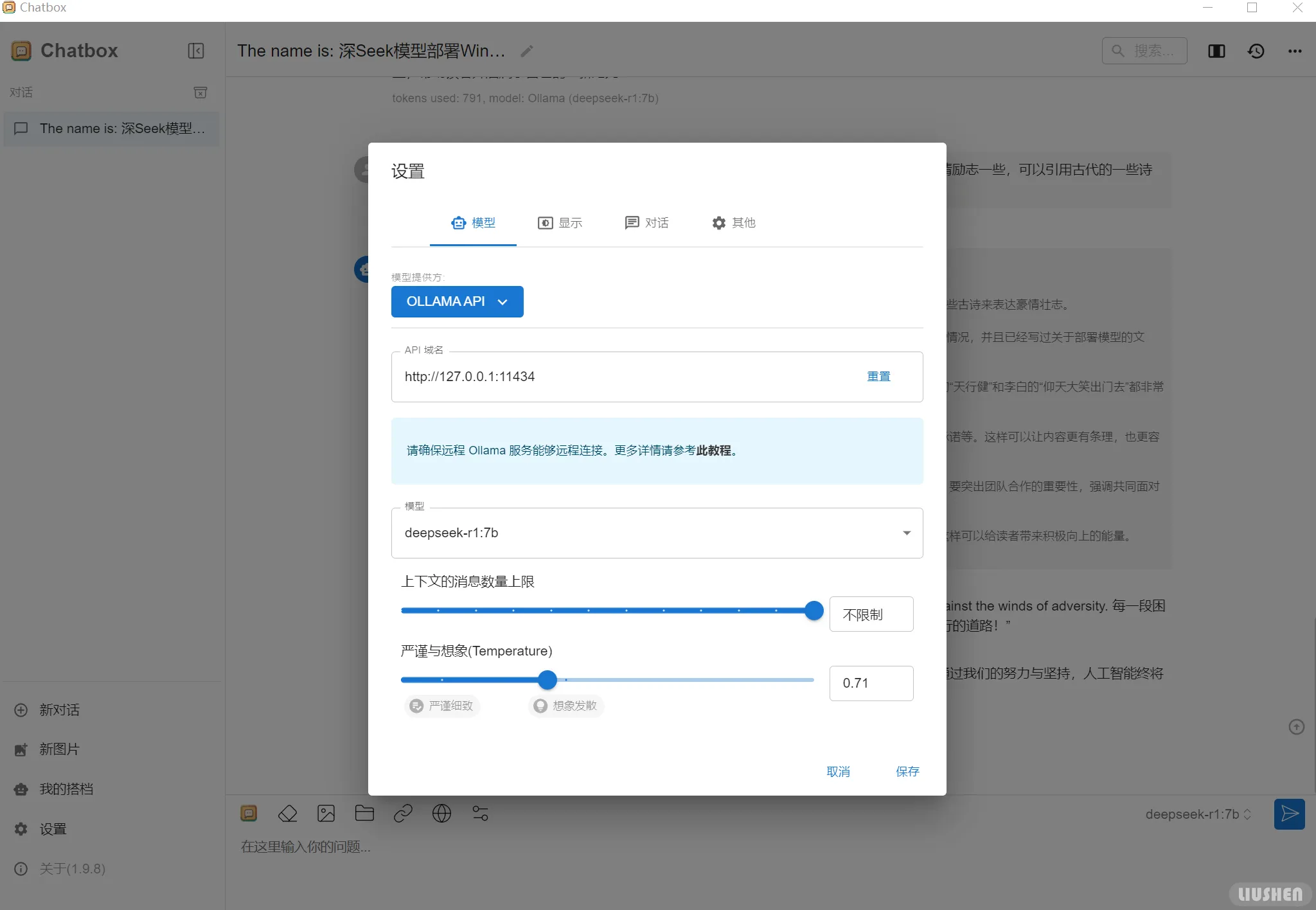

这个设置相比上一个,功能性上略逊一筹,但是更加简单轻量,模型可以自行查询api生成列表,无需自己输入模型名称,在设置中就可以找到模型,按照自己的需求进行配置即可,如下图所示:

这个软件更加轻量化,但是稍加逊色的是界面上的美化,如果不在意这些,这个也是一个很好的选择,下面是界面展示:

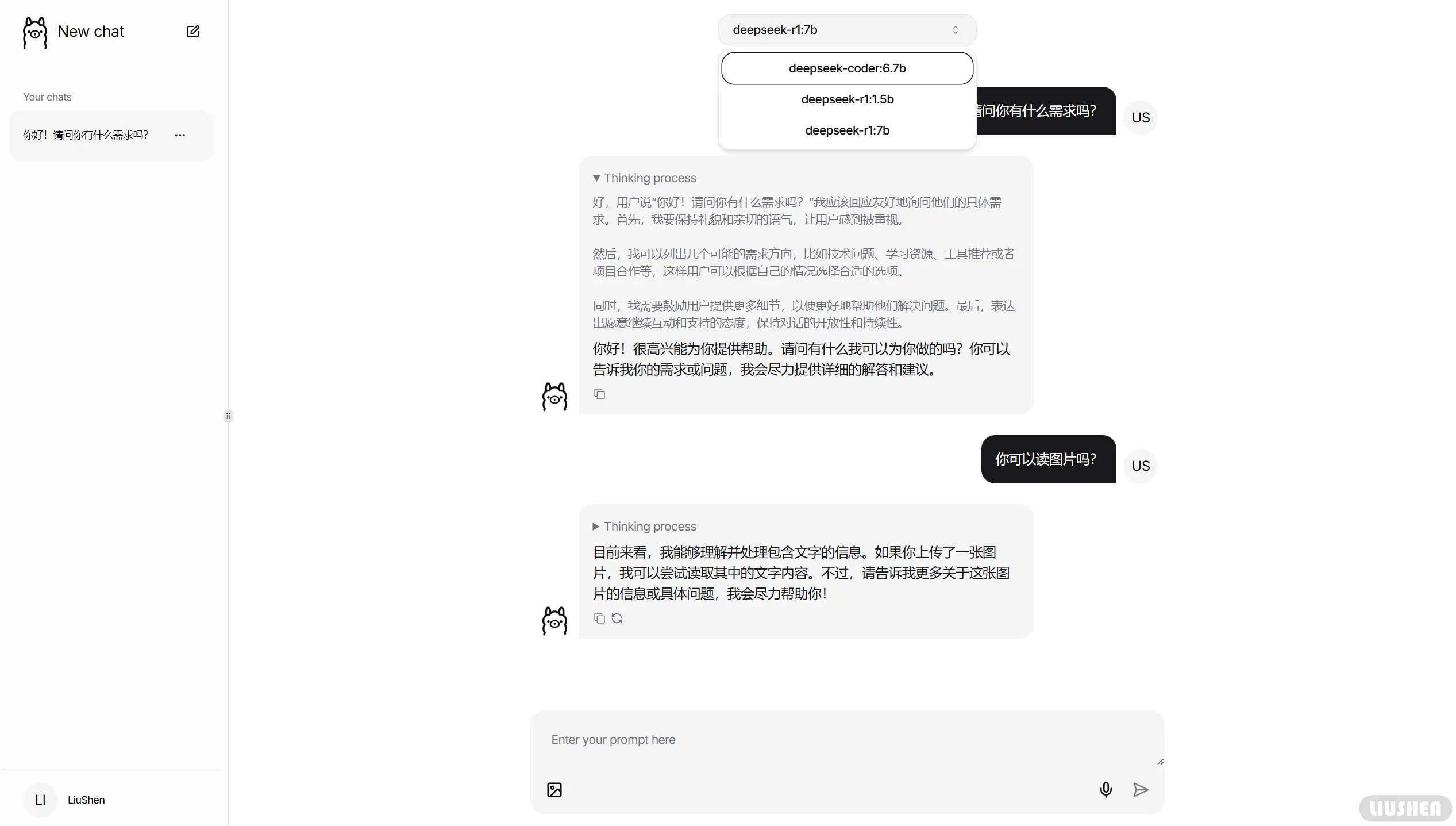

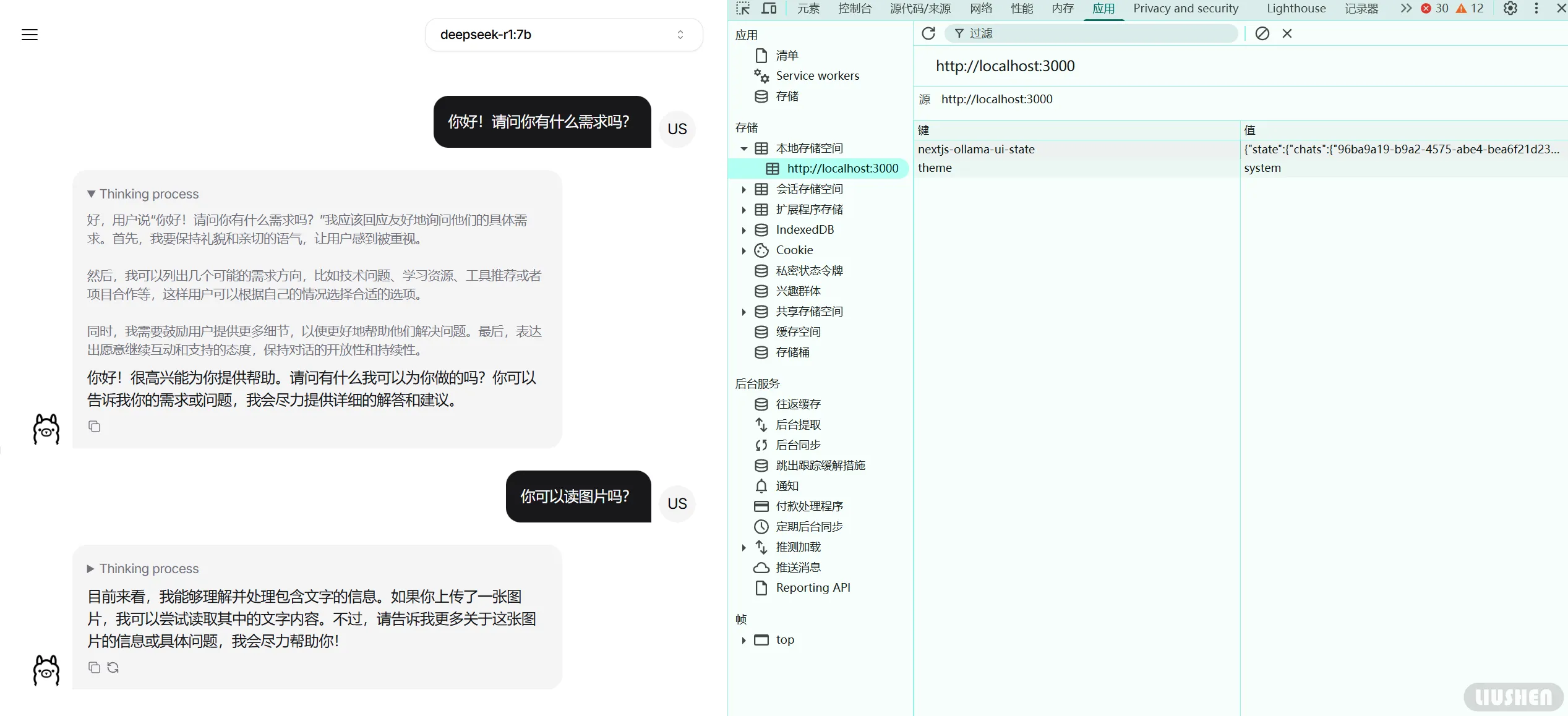

nextjs-ollama-llm-ui

推荐指数:✮✮✮

推荐原因:基于nextjs,只需要有node环境即可使用,界面简单直观,使用webui,适合有特定需求的用户,但是由于基于webui,聊天历史可能无法很好的保存。

项目地址如下:

不用多说,相比于官方的复杂的docker设置,这个轻量了许多,也更加容易部署,但是功能性稍微欠缺,不过基本的对话,切换模型等功能俱全,如果没有很高的要求,这无疑是一个服务器部署的绝佳低配替代。

执行以下命令即可运行:

1 | git clone https://github.com/jakobhoeg/nextjs-ollama-llm-ui |

以上命令也不再细讲,相信看到这里的人都有一定的前端项目基础,这也是最基本的安装包和运行的命令了。下面是界面展示:

不需要过多的配置,用户的浏览记录保存在本地存储空间中,不需要配置api,项目中已经内置,界面模仿了GPT的配置,简单但是直观,适合想要在服务器上部署并在网站上进行访问的朋友。

本地存储空间保存浏览记录的方式虽然可以用,但是仍然不保险,如果想要自己长期用还是建议用软件。

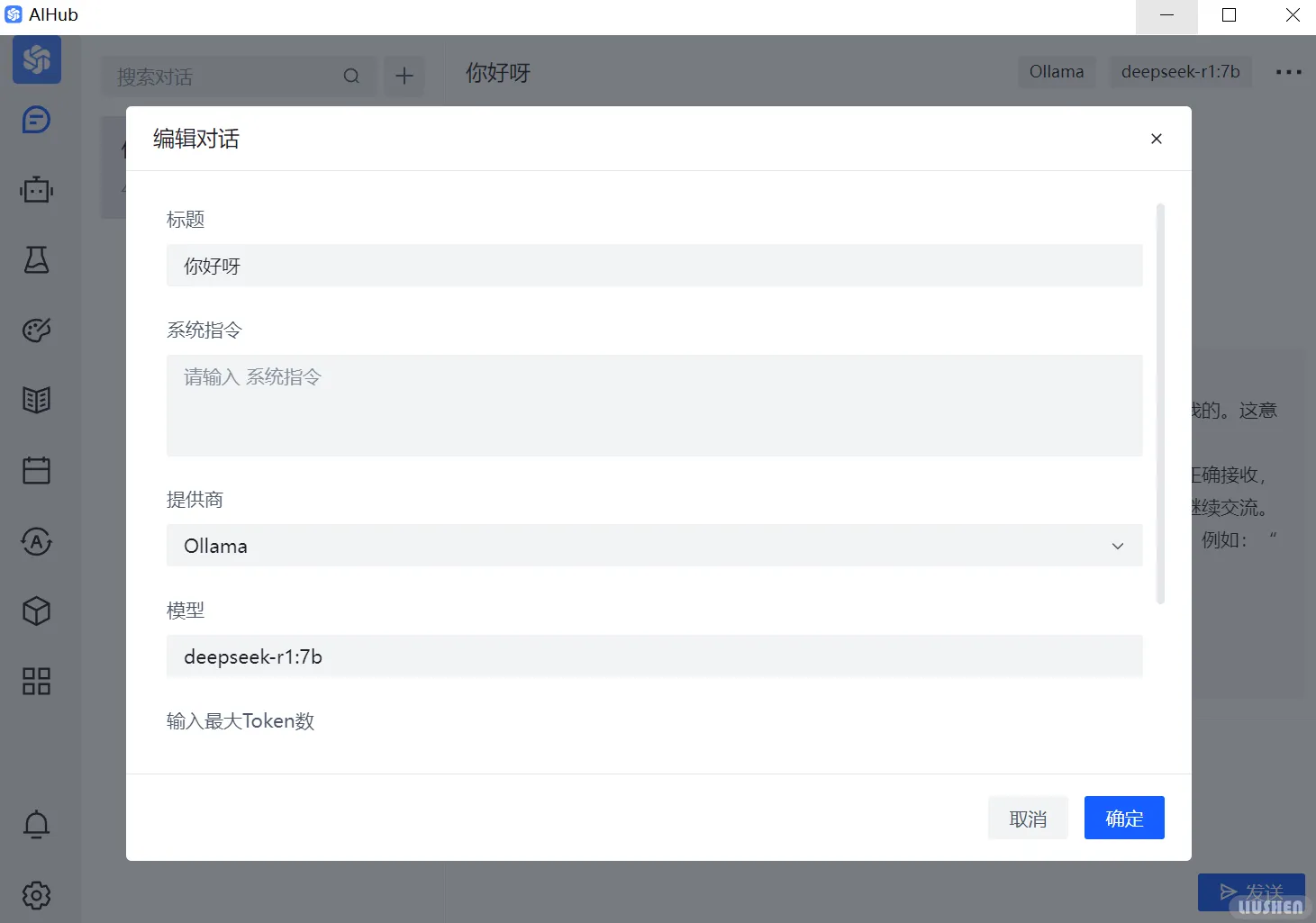

AIHub

推荐指数:✮✮

推荐原因:代码开源,轻量化,但是没有过多的修饰,且默认安装到C盘,需要手动移动。

项目地址如下:

这个软件的代码开源,所以可以放心使用,但是在界面上略显单调,且需要手动输入模型名称,比上面几款来说略嫌麻烦,且默认安装到C盘,需要手动移动到其他盘,界面如下:

配置方面不过多细讲,仅需在页面右上角点击,按照提示配置即可:

and so on

除了这些,还有官方的功能最全面,但是配置也比较麻烦,由于我并没有这方面的需求,所以并没有尝试部署,如果有需要的可以自行部署。地址如下:

还有一些软件,例如chatwise,这个软件优化很好,且界面也进行了相对应的美化,但是唯一缺点就是,在浏览器报毒,虽然我知道这大概率是误报,但是秉持着宁可信其有,不可信其无的原则,在这里我还是不推荐,如果有兴趣可以自行下载,链接如下:

总结

本次部署过程相对简单,deepseek-r1:7b模型虽然在性能上不及当前一些更为庞大的模型,但其轻量级的设计使得它在本地环境中也能高效运行。尽管它不具备超高的计算能力,但是也能很好的胜任一些常见任务,如模拟对话、自动回复等,展现出极佳的实用性。对于需要快速响应、低延迟的应用场景,deepseek-r1:7b无疑是一个理想的选择。

随着技术的不断发展,相信会有更多的开发者探索并扩展其应用场景,创新出更多有趣且实用的玩法。无论是对话生成、文本分析还是图像处理,未来的可能性都令人期待。通过本次部署,我们不仅验证了模型的实际效果,也为未来的研究和应用奠定了基础,期待更多的创新与突破。

参考文章

每日一图

蓝色海洋:来自哲风壁纸